AIGC,即 Artificial Intelligence Generated Content,一种基于人工智能(实际上为机器学习算法)生成内容的技术,包括但不限于生成文本、图像、视频等等,本篇知识库主要介绍 AI 图像生成的相关内容。

说是 AI,但它的本质依然是一种算法,一种对规律的记忆和复现,是一种数学化的总结和组合,并不是抽象的艺术思考和创作,距离多数人想象中真正的人工智能其实还差了很远。

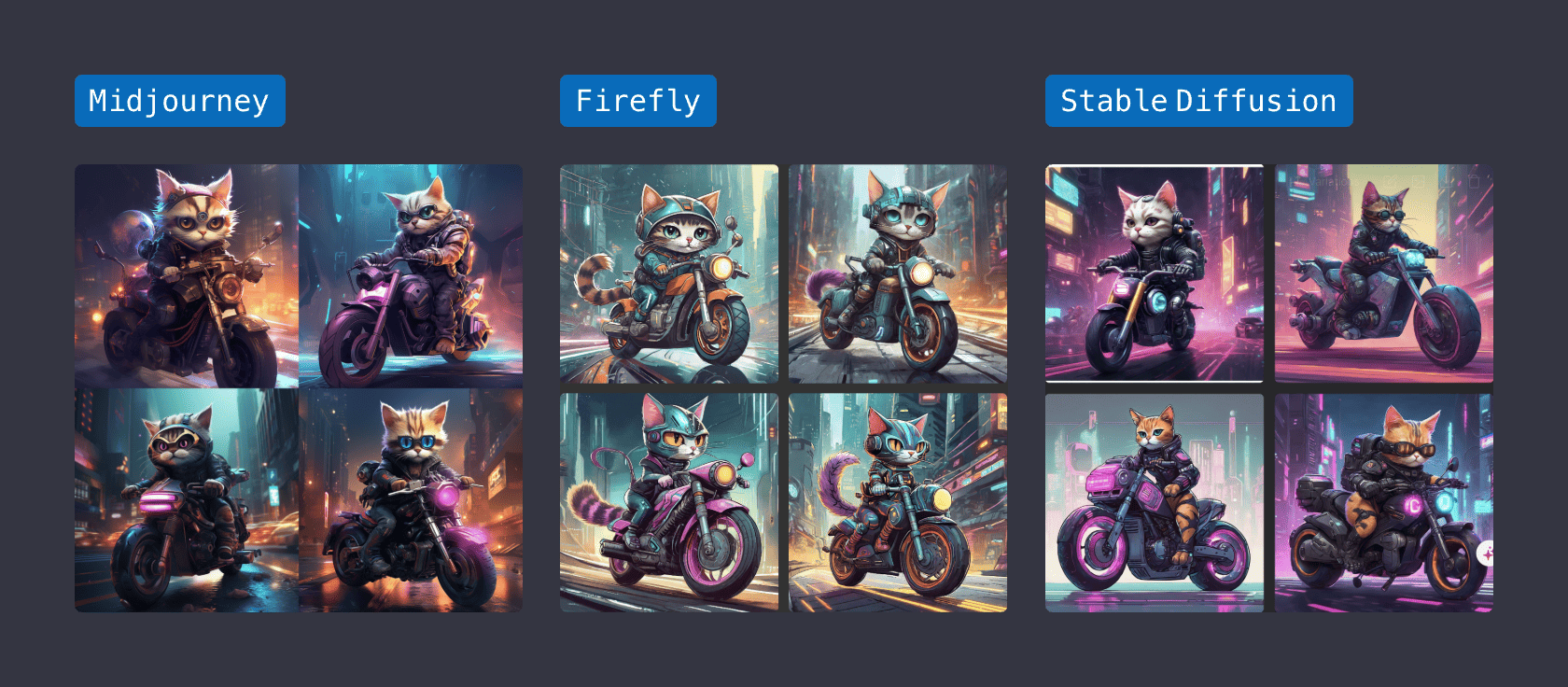

目前市面上涌现出了一大批 AI 绘画工具,这里我介绍其中最有代表性的三个:Stable diffusion、Midjourney、Adobe Firefly。

AIGC 基本原理

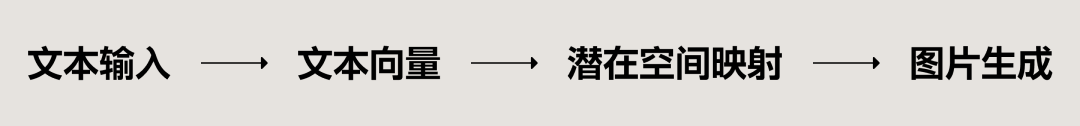

就像把大象装进冰箱只需要三步,所有AI绘画基本上都分为这几个步骤:

1.模型的预训练

步骤中这个潜在空间的映射过程,就是模型预训练的结果,也就是说你训练模型时是如何做文本到图片的对应的,那么生成时候就会大概率做同样的对应。

并且这种对应,是在模型训练完成就难以再修改的。因为模型训练的数据量和计算力需求极为庞大,所以除非大公司有庞大的资源进行模型训练,否则如果是使用现有的 AI 大模型,个人想要进行微调几乎是难以实现。

举个例子来说,之前的 Midjourney 因为缺少字母数字字形的训练,所以生成的所有图形几乎都与具体的字形无关,哪怕你给它指定了图片中需要数字「0」,它也做不到,因为它的模型空间里没有这样的东西。

图片生成器

市面上有好几个不同的方案来实现图片的最终生成,例如 Midjourney、Firefly 主要采用的GAN (生成对抗网络),以及 Stable Diffusion 使用的扩散算法,还有 VAE (变分自动解码器) 等等。

不过不管它们具体使用的方法是什么,其过程大致抽象如下:生成器首先生成一个低分辨率的图片,每一层神经网络会在此基础上添加不同层级的特征和细节,就好像 AI 慢慢地把一副模糊的,低细节的画,画得更清晰、细节更丰富。

在这个过程中,我们不能够进行人为干预,你想要更改其中的某些细节,就需要重新修改 Prompt (提示词,见Prompt是什么),让 AI 重新生成,并且还无法保证你的此次修改能否起效。因为我们无法理解 AI 是如何拆解你的 Prompt 并对应到图片上去的,对使用者来说,这就是一个「黑箱」。

具体的图像生成

每个 AI 绘画工具都会有一个Prompt输入框,通过对应语法输入相关的指令和描述,来生成图像。而每个工具对文本的理解和模型不同,即使用一样的描述生成的东西也不一样。根据前面预训练的说明,不同模型擅长的和画不了的东西也不一样。

所以,下面我们就用一组基本一样的关键词,在不同的工具中生成对应的结果:

这里要强调,想要获得越理想的结果,提示词就要尽可能准确,而且画面结果越复杂,需要描述的字数也就越多,需要氛围感越强,情绪的描写也就需要越生动。想象下那些描写生动的文学作品,能让我们脑子里有画面,语言的描述方式就越细致、越特别。

AIGC 的局限性

AI 绘画再强大,能生成再多让你惊叹的画面,它也有自身的局限性。就像前面说的,它不是真正的 AI,仅仅只是 “一种对规律的记忆和复现,是一种数学化的总结和组合”。

1. 依赖模型

之前说过,AI生成的图像是什么风格,极大程度依赖于它是如何接受训练的,市面上有很多专门针对特定风格的模型,都是这一特性之下出现的产物。

但这也并不能保证市面上有的模型就能百分之一百满足你的工作需要,有些工作方向符合条件的团队,可以自己训练模型,想要模型的效果好,就需要投入很多的人力去进行手工的筛选和打标,且最终的模型效果很难保证。

而 UI 这个领域目前没有这样模型,AI 也并没有建立对 UI 中不同元素的认识和理解,也就是让它生成 UI 界面是随机抄下这些元素进行组合来但根本不清楚自己在做什么。

2.随机生成

生成器在生成低细节图片时,基本上就确定了构图,但这种确定是随机的确定,也就是说你通常很难指定图片中的某样东西,在图片中的哪个具体的位置。这种随机性会消耗设计师大量的精力来进行 rerolling,直到 AI 恰好随到了一个比较符合你预期的构图。

但这样一来,就太依赖 AI 的即兴发挥了,而在 UI 设计中,一个界面从上到下应该包含哪些模块,每个模块里包含哪些字段是指定的非常具体的,和它的随机性是完全背离的。

3. 指向性差

之前所举的 Midjourney 无法生成具体的数字/字母,就是一个指向性差的例子。

Midjourney 虽然非常擅长画人物,画山水,画建筑,但它非常不擅长画抽象的人造物。除了字形之外,它还不能在已有的 IP 形象基础上进行姿势、风格、3D 化变体;对图标、logo 的描绘也比较差 (几乎不可用);对元素进行秩序排列也比较难做好。它太喜欢细节了,这些对人类来说更简单的东西反而画不明白。

4. 难以微调

AI 绘画的每一副图片都要重新生成一次,比如在 Midjourney中,你随机无数次生成出接近自己想要的东西,但是要你要微调里面的内容时,却会发现做不到,每次调整就是生成一张新的图。

而在 stable diffusion 中,虽然可以使用图片局部编辑,但是那个编辑仅仅是根据周边环境对这个区域重新生成,能不能获得你要的结果还是得碰运气。

AIGC 使用场景

AIGC确实可以在一些设计的领域起到革命性的作用,但目前多数是加快这些工作的效率和质量,而不是直接替代,下面罗列一些具体的应用场景。

插画

首先是插画的领域,这个是目前 AI 做的最好也最成熟的方向。不管是游戏 CG 还是概念插画、运营插画,它都可以很好的完成。

当然,基于前面说到的那些缺点,商用环境下是不会直接使用生成的结果上线的,而是要在这个基础上使用 PS 进行修改,或直接以此作为灵感重绘。

所以,要求稍高的商业插画即使引入 AI 依旧需要专业的插画师来操作,只是对他们的要求多了一项使用 AI 得技能。而最底层的插画工人确实失业风险已经近在眼前。

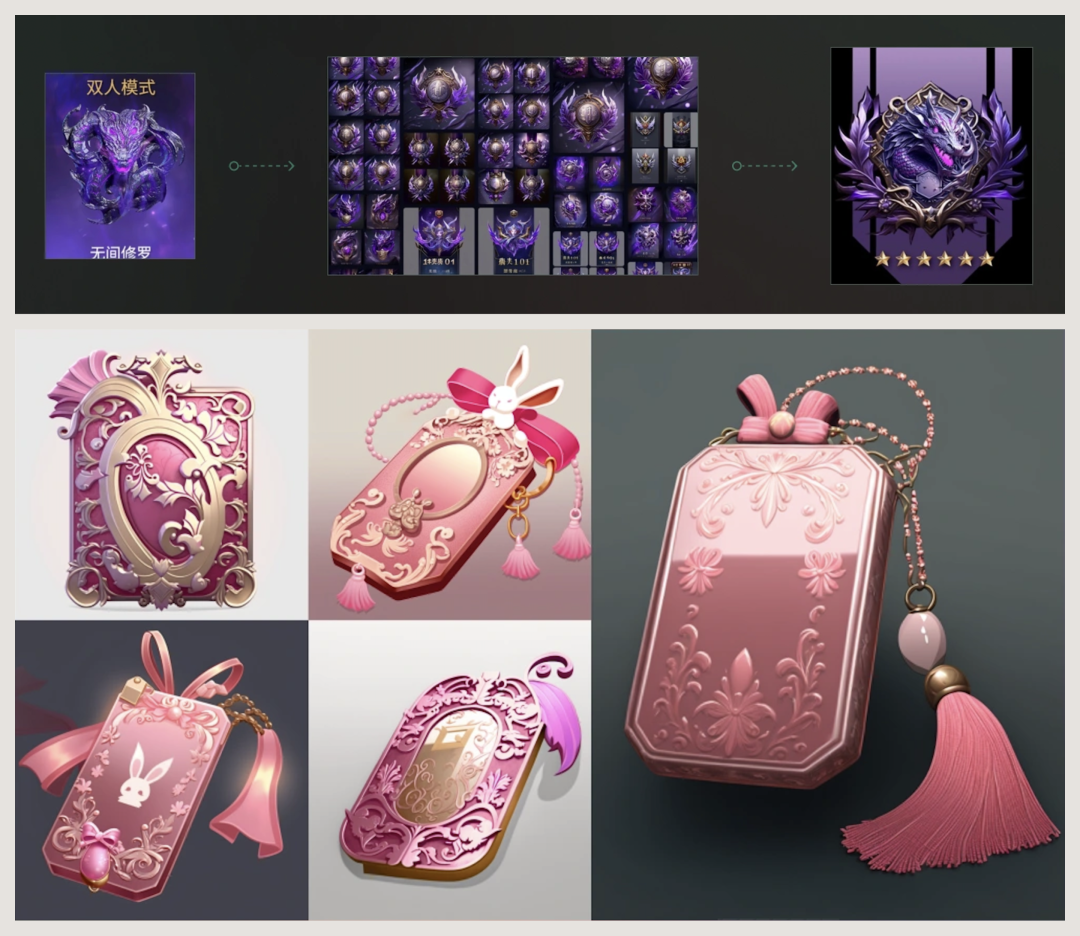

游戏 UI

游戏 UI 也是插画的一部分,只是绘制的范围更小。过去游戏 UI 绘制界面中的图标是非常痛苦吃力的,一个简单的宝箱可能就要画很多版本,绞尽脑汁。而 AI 绘画就可以快速生成大量的版本,这些图直接拿来修改或临摹一遍,大大缩短了出图时间。

这也是 AI插画目前影响最大的地方,因为游戏项目组是非常严格控制成本的,而 AI 带来的效率提升,让个人生成力飞跃,那么自然不再需要那么多的游戏 UI。只要团队跑通对应的流程,就可以立马开始裁员,精简团队的名额,这在各个头部大厂已经实际发生了。

平面包装

平面包装方向也是一个重点依赖抽象图形的领域,对精确度的要求并不高,所以往往有一个模糊的方向和概念,设计师是乐于接受随机生成结果和样式的。

根据目前的实际产出案例质量,包装设计除了外部轮廓,可以大量依赖 AI 来生成需要喷刷的视觉图案。但要记住图案仅仅是包装设计的一小部分,它的结果依旧需要专业的设计师来审视、筛选和修改(需要铺开和添加指定文字),所以会成为一个非常好的工具而不是直接取代包装设计师。

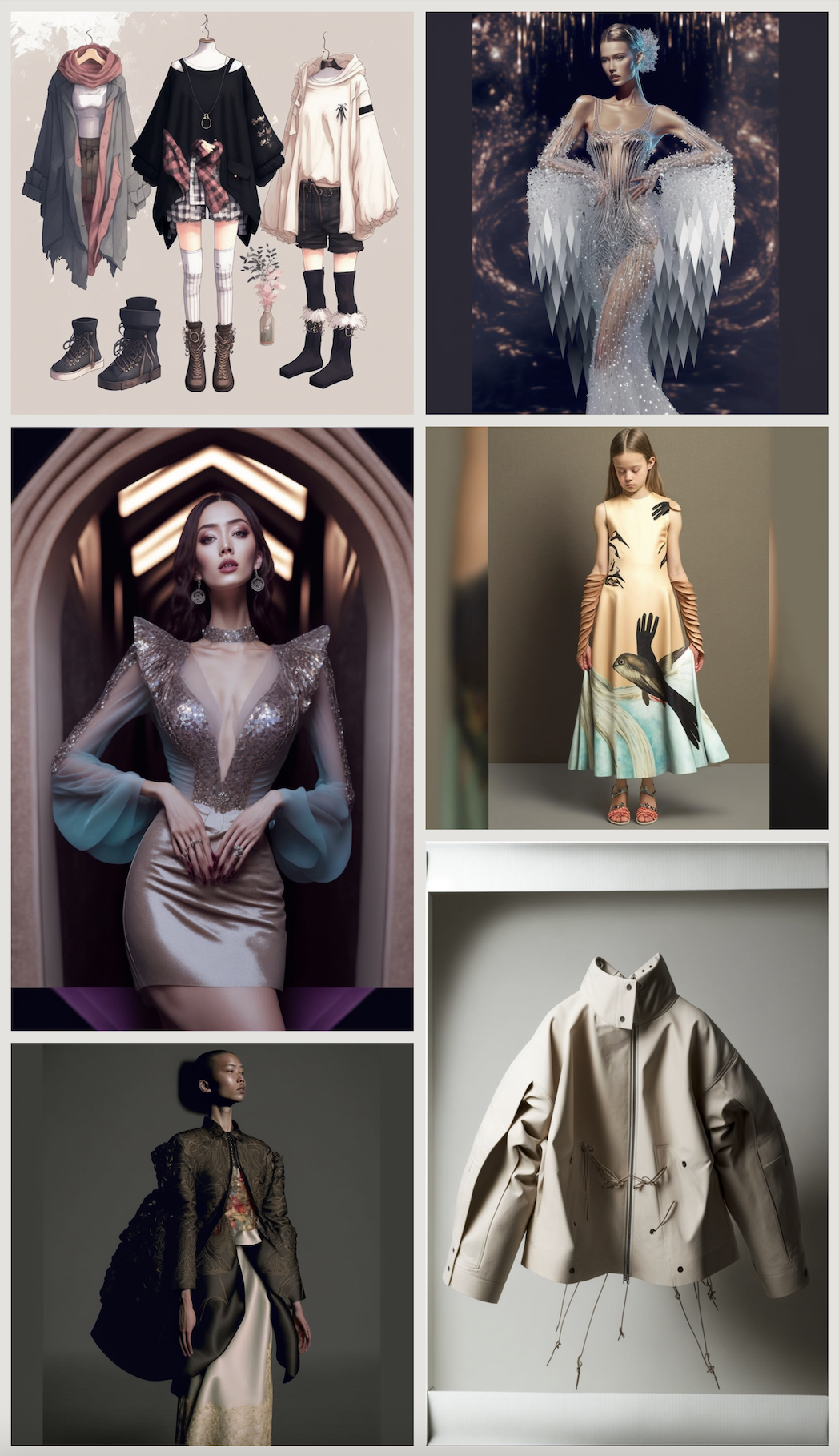

服装设计/摄影

在服装领域,设计和摄影都不同程度受到 AI 影响。服装设计很多时候仰赖一些抽象的灵感和思路,而 AI 的随机性可以很好的提供给设计师灵感,但不管生成的图质量有多高,都需要专业的设计师根据成本、流行、材料、季节的关系对它进行调整,重新绘制和打版。

而在成衣环节,很多时候要拍摄模特图片是要花费很大成本和时间的,而将设计好的服装在模特身上“试穿”已经成为可以实现的功能。虽然目前还有很多缺陷,但可以遇见的是未来肯定会有专用的产品上线,对低端商拍和模特行业产生直接的影响。

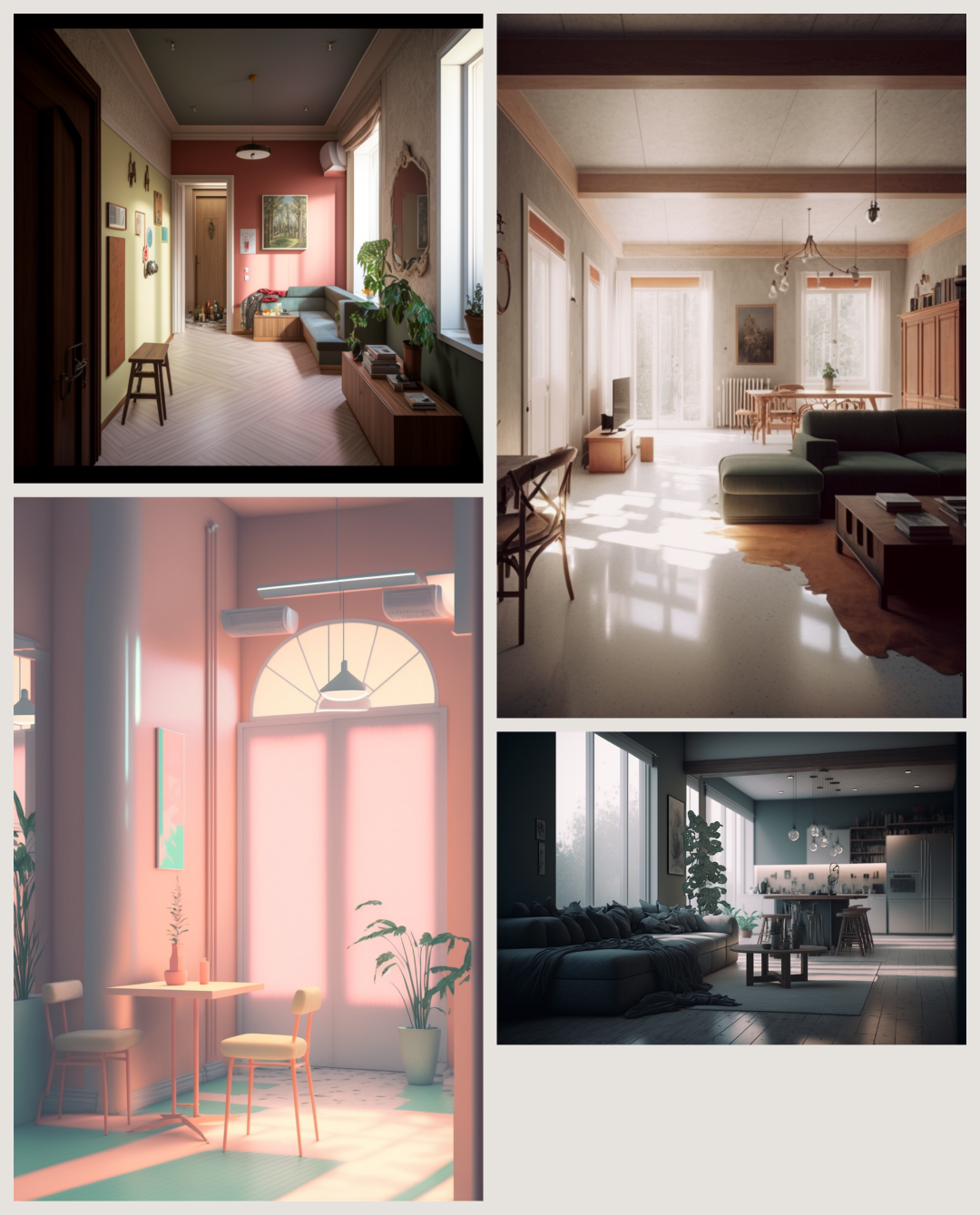

建筑/室内

还有就是因为 Controlnet 的应用,AI插画可以生成更细腻、丰富的室内建筑、室内效果图了,往往产出的质量还不错,远超低端设计师的工作效果。

但是,光靠这种效果图并不能完成最终建筑或室内设计,因为实际场景包含的各种限制、参数、需求是没办法有效反馈给AI让它解决的。所以这些效果图依旧只是飞机稿,为设计师提供灵感的工具。

总结

随着 AI 的发展,不同的设计领域都会引入 AI 绘图结合进设计流程,但说到底它只是一个工具,不可能包办整个项目都出发到落地的所有细节,因为这些关键的信息是在三次元中产生的,而项目又不是工业生产线,可以完全标准化运作。